网络法读书会第二十七期记录

时间:2019-06-10未来法治研究院网络法第二十七期读书会于2019年5月27日在中国人民大学明法楼725室举行。本次读书会上,老师和同学们围绕“ The People, Rules, and Processes Governing Online Speech”、“Free Speech in the Algorithmic Society: Big Data, Private Governance, and New School Speech Regulation”两篇文献进行了主题报告和讨论。

以下是整理的第二十七期读书会主题报告和自由讨论内容:

网络平台与言论规制主题报告

北京大学法学硕士法学理论方向 张鼎

The People, Rules, and Processes Governing Online Speech

一、Introduction

介绍了两个案例,Alton Sterling案与Philando Castile案,在该两案中,有人将案发的经过记录下来,并且发布到Facebook上。作者认为,这两个例子很好的说明了,在一个民主的社会中,这些在线平台对于政治参与的重要性。在Castile案中,视频在网上短暂的消失了一段时间,事实上,平台对于用户内容的调整是常见的,那么是什么原因导致平台调整用户的内容呢?他们为什么要对用户的内容进行调整呢?作者认为自己所解决的问题是,这些平台是如何规制用户生产的内容的,以及为什么这些平台要对这些内容进行规制?通过分析一些公开资料、采访以及内部文件,作者认为,这些平台是一些自我规制的私人组织,他们所治理的正是宪法第一修正案所覆盖的言论自由。其治理的内容反映的是民主文化的性格,以及用户的规范。

二、230条款,第一修正案

和媒介自我规制的发端

在信息时代之前,能够影响言论自由的主要是出版商。在信息时代,言论自由的战场已经转移到了网络平台。

A. 230条款的历史与发展

在美国,有一个条款,赋予媒介巨大的免责权,该免责权使得媒介主体对于用户生产的内容不承担责任。这一条款使得这些媒介平台拥有巨大的自由,正是这样一个法律基础,使得平台能够在今天发展起来,形成今天的自我治理体系。该条款就是CDA230(communication decency act)。在该法案实行之前,有两个案子需要注意:Cubby, Inc. v. CompuServe, Inc,Stratton Oakmont, Inc. v. Prodigy Services Co.在这两个案例中,法院认为,如果媒介平台对于用户生产的内容进行了编辑,那么平台就需要对其内容承担责任。这样的判决思路使得平台既没有动力去扩展自己的生意,也使得平台没有动力去调整一些侵犯性的内容。后来,国会通过了CDA,该法案中的230条规定“[n]o provider or user of an interactive computer service shall be treated as the publisher or speaker of any information provided by another information content provider”。该法案确立之后,通过Reno v. ACLU与Zeran v. America Online, Inc.在Zeran中,法院认为,平台既不承担出版者的责任,也不承担传播者的责任,而且还区分了平台的注意义务。尽管如此,法院还是认同了CDA中的好人条款,该条款鼓励平台对于其平台上传播的侵犯性内容进行自我规制。作者认为,Zeran的重要意义在于,其解释了CDA的立法目的:平台言论自由与平台不适言论的规制都是CDA的目的。不过,一些新的案例并没有按照Zeran的思路进行裁判,比如:Darnaa, LLC v. Google, Inc.;Spy Phone Labs LLC v. Google Inc.

B. 第一修正案的含义

在考虑管控用户的言论与保护用户的言论自由时,根据平台的不同,法院和学者都将这些平台与第一修正案中的学说进行对比。比如,类别为工业城(company town)、广播台与编辑。

第一类就是将平台类别为国家,只有国家才需要承担由宪法第一修正案所确定的肯定义务。但是,私人主体的行为是不是构成了国家行为本身就是很难确定的。类似的案例有:Marsh v. Alabama. 之后的一些案例延续了该案的思路,但是,这些案件都是处理的诸如工业城、商场的事例,在处理网络平台的案件时,法院认为平台并没有实际的执行任何市政权利以及提供基本的公共服务,因此,不属于国家行为。不过,在之后的在Packingham案中,法院认为获取私人在线平台的权利是宪法权利,因为网络平台就是当今的公开场合。这种类比的结果通常是认为,互联网平台并不是宪法第一修正案所针对的主体。

C. 悲观主义着、乐观主义者与现实主义者

乐观主义的学者认为,网络平台就是一个新的言论自由发挥的场合,但是悲观主义学者诸如Lawrrence Lessig则认为,平台的自我规制会威胁言论自由,或者容易被政府俘获。一些学者则认为,网络上一些负面内容,诸如,色情,性骚扰的就是应当被移除。不过,这些讨论都没有关心,这些平台的实际行为。

三、为何治理的很好?内容控制中言论自由规范的角色,公司文化和经济激励

作者在这部分讨论的是网络平台的治理,作者将网络的治理模式称为“新治理模式”:这一模式解释了用户与平台互动的三个特征:动态的与迭代的法律制定过程,生产规范的用户个人,结果与过程的一致性。通过对于经验的分析,作者认为,三个主要的因素影响了平台的内容修改系统:1)对于言论自由的潜在信念;2)公司责任;3)经济可行性。

A. 平台在言论自由上的底线

制定平台内容修改系统的人的确受到了在Zeran中提出的言论自由与附带审查的影响。

1. 言论自由作为一种规范。在Youtube中,对于决定什么内容是Youtube允许的时候,有一个言论自由的底线,只要是合法的不违背平台规则的内容都是可以允许的。最初的Facebook的规则就是一个“无所不包规则”。Twitter则是确立了不管控用户的内容,除非在特定的情形下。这三个平台的历史都有一个共同的特点,那就是,有着言论自由背景以及第一修正案背景的职业美国法律人,目睹了整个修改用户内容政策的发展。

2. 政府请求与附带审查。这三个平台都面临着政府请求的问题,Twitter尽管坚决的抵抗,但是最后还是输给个政府;而Youtube则面临着全球的问题,其需要在全球范围内适用美国的言论自由条款,有的时候,Youtube会向当地政府妥协,但是有的时候,也会不妥协,一旦不妥协,就可能被当地政府屏蔽。而在面对这类问题时,Facebook则确立了如下的规则:

attacks on institutions (for example, [*1625] countries, religions, or leaders) would be considered permissible content and stay up, but attacks on groups (people of a certain religion, race, or country) would be taken down.

看起来,美国的这些互联网平台公司真的很在乎言论自由,不过,为什么这些平台还要对用户的内容进行修改呢?

B. 为什么要修改

1. 公司的责任与身份。有的平台对淫秽、暴力、与可恶的言论进行管制是出于企业责任。Youtube的人员认为,平台创造社区规范是为了服务来到平台的用户的,并且他们希望尽可能多的人加入。同样Facebook的人员也认为,Facebook应当是尽可能的开放与联通的,平台的规则应当尽可能满足用户的考虑,并且鼓励他们在平台上互动。同样,Twitter出于同样的考虑,也发展出来过滤用户内容规则。

2. 经济理由。如果平台能够创造一个用户喜欢的环境,那么用户就是花更多的时间在平台上,那么平台就会获得更多的广告报酬。

四、平台如何治理?规则、过程与

内容修改系统的修正

A. 修改的发展:从标准到规则

Facebook的规则最初都是很简单的,用一张纸就可以记载下来,上面列举的是一些应当删除的内容,比如,希特勒,或者裸体。而在这之前,唯一的指南就是“如果你觉得不舒服,那么就把它删除”。同样的历程在Youtube中也有。Youtube和Facebook都经历从标准到规则的过程。不过,在适用标准的过程中,标准就逐渐演变成规则。这种规则转向也使得这些大公司能够开始大范围的对用户的内容进行控制,因为标准执行起来很容易因人而异,但是规则执行起来,不同的人都可能做出相同的裁判。

B. 规则如何执行:经过训练的群体抉择

规则的执行分为事前控制与事后控制。事前控制在用户上传与发布之间发生,事前控制基本上是通过算法自动完成的。比如,通过图片基因技术,识别图片是不是违规的图片。算法自动识别也是一个逐渐迭代的过程,这一过程通过不断的软件版本更新与机器学习实现。事后控制则是通过人为调整实现的,在用户上传并发布之后,就进入了事后的调整。分为主动调整与被动调整。主动调整通常是用于对恐怖分子与极端主义言论的管控。被动调整则是通过用户来实现的,用户发现相关内容可能违规过后,可以举报,可以举报的内容包括:自杀、暴力威胁、恐怖主义、自残行为;一些不那么紧要的可以举报的内容有:可恶言论、赤裸、色情、骚扰。对于举报内容的调整,有着内部的规范,这个内部规范比公布的外不规范变化的更加迅速。

当一个用户的内容被举报之后,会交给平台专门的内容调整员。在Facebook,有三个层级的调整员。第三层级的人完成最多的工作,第二层级的人监督第三层级的人,并且处理一些更高级的内容,第一层级的人,基本就是公司总部的法务,政策制定者。Facebook第一层级的第二层级的工作人员分散在全球多个办公区。这些人在Facebook内部被称为用户支持小组。

在规则执行的时候,平台通常希望这些人能够使用一些法律术语,比如,关联性,类别、理由、多因素测试等等。考虑到工作人员可能来自不同文化,以及不同的知识背景,这些人在上岗前,需要经过反复的高强度的训练,这些训练可以使得工作人员能够克服文化偏见,情感反应,以期实现中立的适用规则。规则在适用的时候,也深深的受到美国法律的影响,工作人员在适用平台规则的时候,会通过一种法律上的类比方法来适用规则,他们可以类比公共政策、内部规则。

在一个工作人员决定将某一内容删除之后,有的平台允许用户上诉,有的平台则不允许。Facebook就是一个允许上诉的平台,但是只允许对个人信息页的上诉,对于个人的发布的内容,并不允许。不过,在Youtube,任何事项都可以上诉。Twitter则是只要与Twitter规则相关的内容都可以上诉。

C. 系统的修正与多元系统的影响

正如Facebook的滥用标准的变化所揭示的,平台内部规则的变化比平台外部规则的变化要迅速。内部的迅速变化,是平台公司为了能够尽可能的满足用户对于规范的需求,以及期待。平台规则的变化主要受到四个因素的影响:1)政府的请求;2)媒体报导;3)第三方组织;4)单个用户的行为。

1)对于政府请求,政府的干预也会影响平台规则的形成。比如,Youtube形成的规则是除非一项内容违背相关国家的法律,否则不会删除,不过,决定是不是违背该国家的法律的是Youtube自己的律师。如果Youtube认为确实违背了某国法律,那么其就会采取地理屏蔽的措施;不同的是,Facebook所采取的是全球删除。Twitter也是认为,只要违背了所在国家的法律,那么就删除相关的内容。

2)媒体报告。一般而言,媒体的报告不会显著影响,但是当媒体的报告伴随着:1)用户的集体行为;2)公众人物的参与的时候,平台就会回应。

3)第三方组织的影响。一些社会组织也会介入平台规则的制定。比如一个叫做onlinecensorship的组织,就记录被删除的的帖子,鼓励互联网用户说明其被删除的内容。

4)逐渐改变。一旦遭受批评,平台就采取措施,主动的变化。让用户在平台上感受到安全。

D. 如何类比既有的理论

作者认为,无论是将这些平台类比为国家主体,还是公共运营商,都不能够确切的描述平台的性质,或者也是规范上不欲的。如果类别为国家主体,那么不仅直接的与230条相违背的,而且还会使得平台变成大家都不期望的样子,比如,平台可能不再会移除淫秽暴力的内容。如果朝公共运营商类比,问题就在于这些平台本身就是不中立的,而公共运营商是中立的。作者因此认为,应当将其认为是新的治理者。

五、新的治理者

认定是新的治理者即使规范上可欲的,也是满足描述性所揭示的特征。

Platform governance does not fit neatly into any existing governance model, but [*1663] it does have features of existing governance models that support its categorization as governance. As Parts II and III demonstrated, platforms have a centralized body, an established set of laws or rules, ex ante and ex post procedures for adjudication of content against rules, and democratic values and culture; policies and rules are modified and updated through external input; platforms are economically subject to normative influence of citizen-users and are also collaborative with external networks like government and third-party groups. Another way to conceptualize the governance of online speech by platforms comes from administrative law, which has long implicated the motivations and systems created by private actors to self-regulate in ways that reflect the norms of a community.

尽管如此,还是有两个问题,这个模型本身回答不了,1)平等的获取;2)可问责性。

Free speech in the Algorithmic Society: big data, private governance, and new school speech regulation

〇、Introduction

作者在引论提到算法社会这个概念,算法社会指的是:which features large multinational social media platforms that sit between traditional nation states and ordinary individuals, and the use of algorithms and artificial intelligence agents to govern populations。作者认为,在信息时代,言论自由成为最核心的需求。所谓的言论自由就是为了保护和培育民主社会。民主社会就是,在这个社会中,每个人都拥有平等的权利参与政治,并且相互影响,以此,他们建构起来对于自我的理解。早期,人们认为,网络会使得民主成为更加容易的事情,因为,网络使得人们可以越过传统媒体所设置的屏障。作者,认为,在信息时代,第一修正案及其学说正在越来越不适合用于保护言论自由。因为,保护言论自由的任务,逐渐的越来越要私人主体、技术、司法和行政机构来承担。作者还认为,随着商业的发展,网络公司不仅会借用第一修正案来保护言论自由,还会用其来寻求对于个体的监控。在21世纪,第一修正案已经无法为言论自由提供了保护了。算法社会的一个特征是,其收集大量的关于个人和机构的数据用户监控、控制以及歧视。无论公司、还是个人都在使用这些技术手段。而且,在算法社会中,私人公司很容易就被政府俘获,用于政府的目的。在这样的背景下,言论自由在算法社会中,其实是受到威胁的。

一、大数据就是“人吃人”

在算法社会,大数据就是石油。算法社会的基础是大规模的数据收集。同时,大数据在算法时代也是权力的象征,谁掌握了数据,谁就掌握了权力。在算法社会中,重要的财富形式有:知识产权、信息安全、大数据,元数据。某种程度而言,算法社会就是全知全能的。但是,谁在这种全知全能背后呢,是政府与商业组织,他们收集、分析数据,并且由此行形成新的经济权力。虽然大数据来自人群,但是这些数据最后只是被少数人知道,少数人控制,被收集信息的人并不知道。某种程度上,大数据就是由人造成的,也就是,大数据本身就是人。

A. 技术调整人与人之间的权力关系

通过技术收集到的大数据被用来做决策,当大数据被用来决策时候,其调整了那些被收集数据的热恩的关系,也调整了那些决定相关的人的关系,并且调整了他们与政府、公司和那些运行技术的人的关系。因此,对于大数据的担心并不是担心机器人,而是担心人和公司。相比工业时代,人们为了契约自由和财产权而斗争,在算法时代,人们则是表达自由(freedom of expression)。由于宪法第一修正案保护言论自由,因此公司可以收集、分析和使用这些信息,因此,宪法实际上在保护信息的收集、整理、使用和传播。因此,问题在于,算法时代,宪法第一修正案究竟应当保护什么呢?此处,作者引入了两个概念,一个概念是信息信任(information fiduciary)与算法妨害(algorithmic nuisance)。

B. 信息信任

信息信任值得是双边信息不对称的情况下,一方将自己的私人信息委托给另一方以期获得另一方的服务。在传统的社会中,信息信任的例子诸如,律师、医生。第一修正案并不禁止国家对有的职业活动的信息信任问题进行规制。之所以允许的原因在于,这其中的信息并不具有公共意涵,因此,政府可以规制。在算法时代,信息信任机构就是那些收集个人信息的大的组织与企业,比如:互联网服务提供者、搜索引擎、社交媒体。但是,算法时代的信息信任机构与传统的信息信任主体有着不同:

1)信息金钱化;2)鼓励多说;3)用户是不是寻求帮助。

因为以上三点不同算法时代的信息信任机构应当承担更少的责任。其唯一的义务时不能有道用户上传私人信息然后背叛。

C. 算法妨害

需要明白,在互联网中,不是所有的用户都与相关的公司签订了合同,有的时候,合同关系并不存在。但是,有的时候,被收集的个人信息包括个人的特点,建构个人的身份的内容,个人的人际关系以及机会,甚至脆弱点。这就是,算法妨害。因为收集的信息会反过来建构个人的身份、特点和人际关系,然后反过来,影响这个人的未来的机会。这样的行为给个人负担了不正当的成本,因为其使得个人可能丧失一些机会,或者变得更加的脆弱。算法妨害类别的是普通法上的侵权妨害,当有侵权妨害的时候,国家应当颁布新的法律或者新的规章来回应问题。因为在算法中,个人被贴上一些标签,而这些标签可能是错误的,或者存在歧视。即使不存在这些,一个公司也不应当如此摆布人。不过,这还可能导致个人的行为都趋同于算法的要求。而且,这些算法机制,并不是透明的,没有可问责性,没有经过正当程序。

D. 个人机器人

个人机器人可能随时随地都在监控我们。

二、言论规制新学派与私人规制

第二组议题关涉的是被遗忘权与假新闻。在信息时代,对于言论自由规制的根本性转变正在发生。这种变化有两个要素可以掌握:1)政府如何规制或者尝试规制;2)私人拥有的公司开始言论治理。

A. 被遗忘权与假新闻

被遗忘权是欧洲数据保护法创设的学说。该学说认为:

The European Court of Justice has held that the right to forget requires search engines to remove links to webpages containing information about people that is “inadequate, irrelevant [,]... no longer relevant, or excessive” to ensure that other people will not have easy access to the information.

假新闻问题是在2016年特朗普选举时发生的。一些假新闻被用来混淆视听。有很多人希望对假新闻这种问题进行规制。无论这种规制是来自于政府还是来自于媒体。

B. 言论规制新学派

假新闻与被遗忘权,在作者看来,都是一个更大现象出现的说明,那就是他所谓的新治理学派。传统的治理方式,主要针对的出版商和说话的人。而新治理的方式,则是针对的信息基础设施。所谓信息基础设施,包括:云服务、DNS、网络服务提供者、网络主机系统、社交媒体、搜索引擎,还包括支付系统。

新治理技术包括三个特征:附带审查、公私合作或者俘获,私人治理。

1. 附带审查

当政府采取媒介责任时,就会有附带审查。由于平台需要对平台上的言论承担责任,平台就有激励去管制平台上的内容。其所采取的手段包括事前的和事后的,事前可以进行筛选和屏蔽,时候包括删除。

2. 事前限制

由于附带审查是官僚体制作出的,这使得相对人并不能申诉,或者被告知。另一方面,由于行动的负担被踢开,那么,任何人除非得到事前允许,那么他都不会说话。因此,这使得,新的治理方式,也成为了事前限制。因为如此,政府给媒体提供了一定程度的豁免权。该豁免权是由1996 telecommunications act和千禧年数据版权法案所支持的。

C. 公私合作/俘获

此处的公值得是政府,此处的私指的是网络提供者。公私合作或者俘获指的是政府与网络服务提供者联合起来,或者,政府采取措施,俘获私人企业,从而实现对言论的控制。不过,这也不是完全的合作,或者俘获,其合作的程度就如同一个光谱一样,有的时候,合作程度很高,有的时候,很低,比如,关涉网络安全的时候,合作就高。不过,除了与政府的合作会使得他们进行治理外,他们也会进行自我规制,自我规制的原因可能有:经济利益,为用户创造安全的舒适的网络环境,向其他合作伙伴表明他们的控制能力,或者,创造更大的社区。

三、私人规制

自我规制意味着网络基础设施的提供者对用户的行为进行控制。他们控制的能力来自于通信法,私人产权、合同关系。其实,这些平台最开始认为自己仅仅只是软件工作,但是随着情况转变,他们面临着两方面的压力,一方面的压力是政府,越来越期望他们进行控制,另一方面,用户也越来越希望他们对平台进行控制。

其实,互联网平台对于用户的内容的控制很早就开始了,早期的时候,他们就是那些我们游戏中的那些“神”,现在,他们也在进行控制,发展成了一个多边的结构,在这个多边的结构中,平台与以前的媒体其实就不同了。以前的平台,主要编辑用户的内容,选择用户的内容进行发表,但是,现在的平台,则是希望越来越多的用户加入进来。这也使得,公民的言论自由其实与以前公民的言论是不一样的,在规制公民的言论自由方面,多个主体之间进行权力竞争;这也使得,公民的言论自由的能力与以前其实也不是样的;最后,这些私人治理者的规范,不仅仅是用户的规范,而且还有着平台自己的规范,其产生没有经过正当程序。

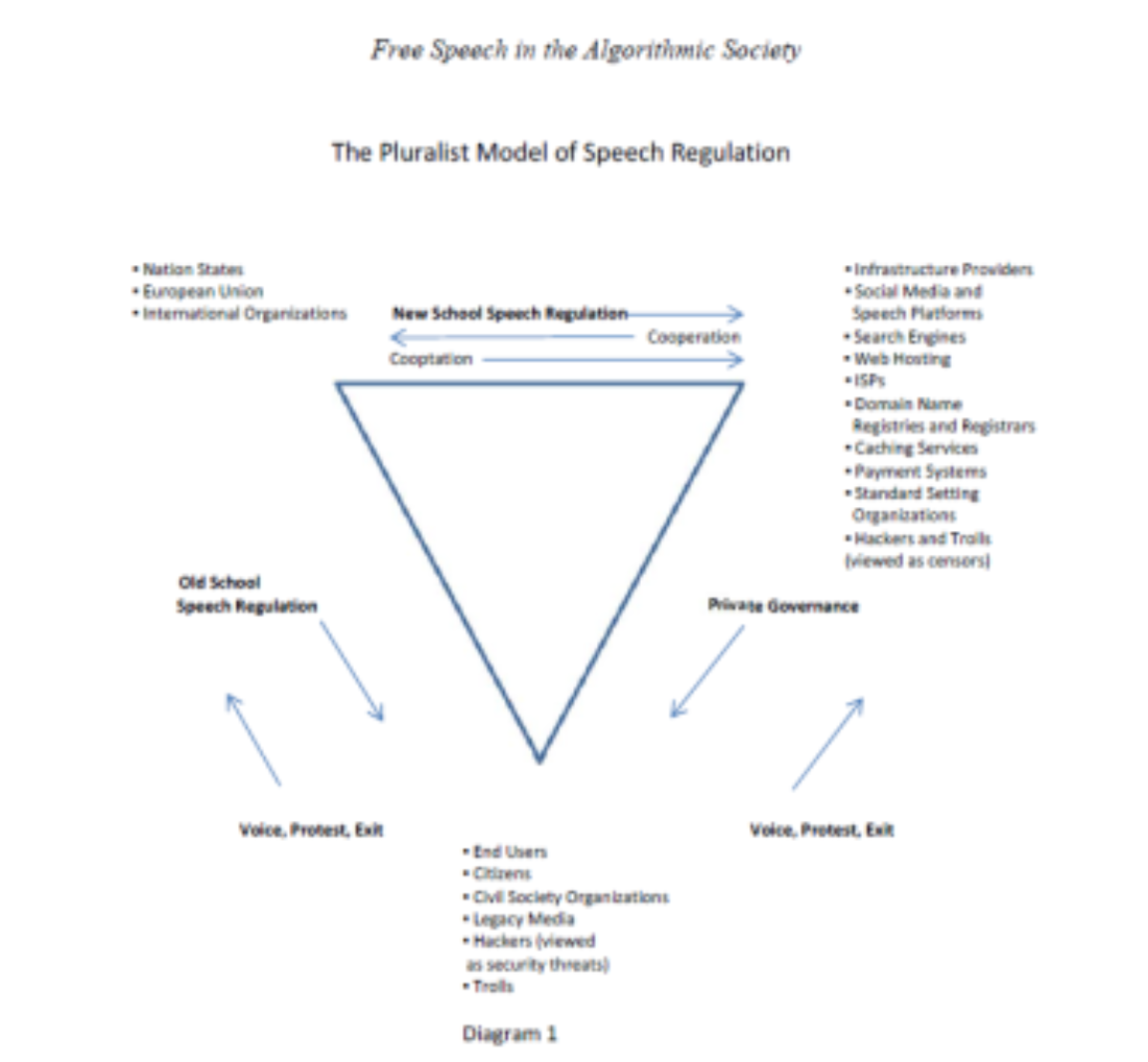

文章所提到的多边结构:

自由讨论

熊文聪 中央民族大学法学院副教授

我觉得一个重要问题就是言论过滤。这套机制,不仅过滤了侵权的内容,还可能过滤了自由表达的言论。在目前的侵权责任法中,存在一个反通知机制,而反通知一定程度上发挥了保障言论表达自由的功用。但是,如果引入过滤机制,很可能造成连发表的机会都没有了。我很希望了解国外学者是如何解决这个问题的。如果一个期刊,不同意发表我的文章,我可不可以起诉它侵犯我的言论表达自由呢?显然不能。现在换成网站呢?会不一样吗?我觉得也不能,因为A网站不同意发表,并不代表B网站、C网站等其他网站也不愿发表,只要文章有质量,网站之间为了竞争肯定愿意发表好文章。但是,如果某家网站取得了支配地位,垄断了言论表达的市场,或者说私人网站成了政府管控的代理人,这可能就成了一个问题。美国学者的文章之所以创设new governor这个概念的意义就在这,因为美国宪法第一修正案只能用来监督政府的行为,而私人网站不是政府,无法适用宪法第一修正案,但如果通过扩张解释,将具有垄断地位的私人网站或作为政府代理人的私人网站视为new governor,就可能解决这一法律适用难题,实际上就是第一修正案的适用得到了拓展。

刘晓春 中国社会科学院大学互联网

法治研究中心执行主任

第一篇文章是描述性的,第二篇我也觉得是在做一种描述的努力,描述不同主体之间的权力结构。比如,内容管制就是一种权力结构,平台对于言论和内容的管制,是基于内容管制的规则获得合法性,背后体现的合法性是政府对个人的内容管制。另外一种权力结构,是言论自由,是个人对抗政府/平台管制言论的合法性基础。在互联网领域,围绕信息控制,还有很多其他权力结构,比如个人信息其实也是一种个人对抗政治和商业主体的权利依据,在这个意义上我个人一直认为,个人信息的保护应当不是工具,而是本身就是目的。

关于平台责任和角色的理论,我个人认为是网络法领域最令人兴奋和最具有突破性创新产生可能的问题。我比较认同文章中New Governor的提法,尽管这种思路并不算那么新鲜。目前我们如果还是以一个纯粹的私主体去看平台,或者以合同法规则去研究平台治理的规则体系,注定会在理论上遭遇困境和失败。除此之外,我认为,平台的治理相对于政府的治理,其实更多的不是取代,而是竞争,它提供了新的空间,这个新的空间,交织在旧的空间上。我之前写过一篇文章,关于电商法的知识产权条款,该条款试图将知识产权的问题引流到政府规制上,我的结论是,这种引流是不现实的,对任何一方都是不合适的。在纠纷解决上,我认为,应当由平台来承担主要的责任。电商平台上,产生的纠纷,如果不交给平台解决,其实很难提供有效率的解决方法。这种新的治理方式会倒逼传统的治理者去探索更加创新的治理方式,去适应这个时代的需要。

沈伟伟 宾夕法尼亚大学博士

第一篇文章类似于人类学的研究,获得这些资料很不容易,得找对人,得人愿意说,得说完还同意发表。这些新的治理者,就是这些互联网巨头。在我们身边,都有这篇文章提到的这些平台和技术。文章主要探讨了平台作为私主体,其治理背后的逻辑和具体的实践,是一篇不可多得的实证材料。当然,作者的贡献可能也仅止于此。

第二篇的文章作者是Balkin,他了不起的地方在于创造了一个针对网络言论的第一修正案理论体系。这篇文章讨论的是网络言论理论框架的细节之一,最重要的是在16年文章里提出的信赖义务(fiduciary duty)之外,提出了算法妨害(algorithmic nuisance)的概念。整个理论细节我就不重复了,我大概梳理一下这两篇文章的理论背景。

我们必须明确一点基本的法理,这是讨论的基础,那就是:第一修正案只针对公权力机关对于言论的限制,这在美国宪法里的概念叫state action doctrine。(第1195页,第124脚注)这话反过来讲,私主体对于言论自由的限制,是不受第一修正案制约的。举个例子,比如说,特朗普twitter胡话连篇。国会看不下去了,出台一个法案要求所有人发推讨论公共议题,需经过国会设立的特别委员会审核。可不可以?不可以!第一修正案保护个人发表政治言论的权利。同样,特朗普twitter胡话连篇,他老婆看不下去了,把他手机给没收了。可不可以?绝对可以!私主体限制言论不受第一修正案制约。同样,特朗普twitter胡话连篇,twitter看不下去了,把他账号给停了。可不可以?基本上可以!理由同样,私主体限制言论不受第一修正案制约。为什么说twitter“基本上”可以?而不是像特朗普老婆那样“绝对”可以呢?是因为有两个例外。- 第一是company town问题,1946年 Marsh v. Alabama案中,最高法院判定有些私主体可以转变成公主体。但美国法院一而再再而三地驳回“将平台划归公主体”这一诉求。第二,国家借助私主体进行规制,也就是Balkin所称的New School Speech Regulation。基于这个大前提,我们就不难想象,为什么像Balkin、Fiss、Sunstein这样的第一修正案学者,对于网络言论规制,采取了“政府-媒介-发言者”三元模式,有别于传统的街头发言人的“政府-发言者”二元模式。也正因为三元模式的存在,第一修正案的保护已经不足以应对言论自由的威胁,甚至可能成为保护言论自由的绊脚石,于是,Balkin其实就是谈,那么怎么样在这个三元的架构里面,保护言论自由。他借助的,不是第一修正案(甚至要摆脱第一修正案),而是两个新的概念:如果存在合同关系,适用fiduciary duty;没有合同的时候,适用algorithmic nuisance。

吴玄

第二篇文章中提到的三方关系是理解网络社会规制的关键。如今,随着网络世界与现实世界的联系愈加紧密,网上行为不再局限于虚拟世界,对线下人们的生活也会产生深刻影响。在此背景下,运营商平台的地位和作用凸显出来,事实上在履行一定的公权力职能。那么我们应当思考两个问题:第一,平台的这个权力来源于何处?第二,谁来监督平台?关于第一个问题,有两个讨论的路径,一是来源于公权力(政府)的授权,因为平台的技术优势,公权力的监管能力(包括立法执法司法)滞后于网络发展,采取主动授权或强制归责的方式,要求平台规制网络言行;二是用户协议/契约,用户为了使用平台服务,主动或被动地让渡一部分自由接受平台的规制。第二个问题就复杂一些,如第一篇文章中所提到的,平台采取的规制手段和措施都是不透明的,为什么我们要去相信一个平台对言论的规制一定就比国家做的更好呢?美国学者一直警惕国家对个人言论的压制,所以第一修正案是作为限制国家权力被经常提起的。那么在网络世界,平台实质上拥有的能力是不亚于国家的,甚至可以在个人完全没有察觉的情况下,通过算法诱导、规制个人的言论。要尤为注意,平台不仅拥有自己的利益,也拥有自己的立场,并不是完全中立的存在。如何确保平台的规制就一定是公正呢?如果不能,那个人为何还应当受其规制?

丁晓东 人大法学院副教授

补充一下有关言论自由的一些背景性理论。一般认为,美国的言论自由理论有三种。一是思想自由市场,即认为言论与思想竞争可以使得真理脱颖而出。二是人民自治,即认为言论有助于人民传递自己的主张,或者有利于人民获取信息。三是自治理论,即认为言论有利于个人自主。第三种理论较位边缘,前两种理论则较位主流。从三种理论出发,可以发现平台对言论进行规制,其实也是有基础的。第一,市场理论,既然普通市场需要言论规制,那么言论市场可能也需要。第二,人民自治理论,人民要发出真正代表人民的声音或者获取真正有效信息,可能也都需要对言论的传播与获取进行合理对规制。第三种理论,则和隐私保护与数据规制非常契合,缺乏对隐私与数据的合理保护,个体就无法实现自主。

另外,还可以比较一下中外的言论规制哲学,中国的互联网规制与西方的互联网规制是完全不同的。在我们国家,一方面,我们党和政府的理论其实也是鼓励言论表达与监督的。另一方面,对言论规制的哲学基础是伦理化规制,即要求言论符合政治与社会伦理,这一点从今日头条的算法规制问题上就可以看出。从这一点上来看,可以发现Balkin的理论再往前推一步,就和伦理化规制具有类似之处了。Balkin在文献提到了用Nuisance的理论讨论企业可能的算法伤害,这是一种防微杜渐的思路,从规制策略上来看,就要求日常的言论能够符合伦理,使得言论能够既能发挥其正面的各种功能,又能将其负面的一些问题降到最低。

杨瑞琦 中央民族大学研究生

欧盟2019年3月通过了《数字化单一版权指令》,同时要求成员国在两年内根据此《指令》制定相关细则,将其逐步变为国内法。版权过滤义务被规定在第17条(原为2016年颁布《指令草案》第13条)。这一条要求依赖用户创作内容(UGC)的平台在用户上传的内容时,阻止未经授权的版权内容在平台上发布。如果互联网平台出现了侵权内容,用户的侵权行为需要这些互联网平台公司来承担法律责任。世界上数以万计的信息产品生产者和信息产品使用产者需要被匹配,最终被多重因素所决定某一信息在任何特定时刻与特定信息交换内容。现阶段产品消费者和平台的选择都是:让用户自己识别自身更愿意接收到的讯息。因此,从产品消费者导向的角度来看,平台是决定哪些信息被接收到的关键工具。和传统讯息接受渠道不一样——传统消费者看电视只看自己感兴趣的频道、看书看报内容都由自己挑选——网络平台推送内容不是一静态的工作形式呈现给用户,相反,最终结果是“动态”生成的,被呈现的内容大多是根据消费者自身偏好——虽是消费者本身自己特定查询或主动选择的,但是最终用户难以脱离平台为其寻求的内容范围。最好的版权保护方法就是上传之前过滤,借助数字化的力量把控好信息传播源头 。互联网的未来是去中心化的,人类需要让渡出这个世界的部分,至少是虚拟世界一定的控制权。马克思在《共产党宣言》里面,提到过一段著名的话:“一切坚固的东西都烟消云散了”。放在互联网治理的维度依然很贴切。不必恐慌,这将是未来互联网社会的常态。技术和法律两者耦合,通常是法律追赶技术,技术降维打击法律,但这一次平台过滤义务给此种传统撕开了一个裂口,代表了人类社会,至少是欧盟社会新一轮对信息使用规则的紧缩,对版权产品的保护,有很好的指向性意义。人工智能时代就要来临,笔者曾经做梦梦到电影里的情节:超级人工智能时代,超级机器人开始反击人类。届时,人类能够怎样对人工智能进行治理?是预先设定一个更为容易控制程序?还是到最后一刻拔掉电源线?未来已来,此次的过滤义务反应了人类的基本倾向则:警惕越来越强大的平台权利,在保护版权人利益、促进技术进步、满足信息消费者三者利益之间,竭力找寻一个平衡点。保护版权人和社会公共的利益,永远拥有法治社会最高的价值位阶。